Descrizione Attività

Le attività di ricerca si focalizzeranno sui processi volti a rendere più naturale l’interazione uomo-robot (HRI). In particolare, si studieranno e implementeranno modelli di interazione antropomorfici su piattaforme robotiche, primariamente umanoidi.

Architettura Software e Funzioni Cognitive

In questo contesto, si intende sviluppare un framework software basato su ROS (Robot Operating System). Tale framework integrerà funzioni cognitive di alto livello, progettate per facilitare l’implementazione e il testing rigoroso dei paradigmi di interazione sviluppati.

Interazione Vocale e IA Generativa

Riconoscendo l’interazione vocale come una delle modalità comunicative più intuitive, il gruppo si concentrerà sullo sviluppo di modelli di dialogo avanzati. Questi saranno basati sui più recenti progressi nel campo dell’Intelligenza Artificiale Generativa, sfruttando specificamente le potenzialità dei Large Language Models (LLM).

Approccio Multimodale e Linguaggio Interno

L’interazione umana è intrinsecamente multimodale: sebbene il linguaggio verbale sia centrale, informazioni non verbali come la gestualità sono spesso determinanti per la corretta interpretazione dell’intenzione comunicativa.

Per gestire questa complessità, l’attività prevede lo studio e l’implementazione di un linguaggio di interazione interna (un intermediate layer). Questo linguaggio medierà tra il sistema conversazionale (LLM) e i sistemi di attuazione del robot, garantendo la capacità di codificare e sincronizzare gli aspetti multimodali della comunicazione (parola, gesto, prosodia).

Comprensione Non Verbale ed Empatia

Un asse di ricerca fondamentale sarà l’interpretazione dei segnali non verbali dell’interlocutore umano. Sfruttando flussi sensoriali 2D e 3D, si studieranno:

• La gestualità e il linguaggio del corpo.

• Gli atteggiamenti posturali.

• Gli aspetti più ampi della metacomunicazione.

L’interpretazione di questi segnali non verbali integrerà l’elaborazione del linguaggio naturale. L’integrazione efficace di questi canali è un prerequisito fondamentale per lo sviluppo di abilità empatiche nel robot, permettendogli di adattare la propria risposta al contesto emotivo e situazionale dell’utente.

Capacità Espressive e Deittiche

Parallelamente, si lavorerà sulle capacità espressive del robot, come la prosodia vocale (il tono, il ritmo e l’enfasi da utilizzare durante l’interlocuzione). Ulteriori modalità espressive (es. espressioni facciali, gesti) saranno implementate in base alle specifiche affordance della piattaforma hardware utilizzata.

Un altro aspetto caratterizzante riguarderà l’implementazione di capacità deittiche (o indicali), ovvero l’abilità del robot di indicare fisicamente oggetti nell’ambiente per riferirvisi verbalmente (es. “Prendi quello”). Questa funzione, complessa da realizzare, richiede un controllo a catena chiusa (closed-loop control) che integri il puntamento gestuale con sistemi efficaci di riconoscimento e localizzazione degli oggetti.

Sviluppo Hardware e Prototipazione

Il gruppo si impegna inoltre nella progettazione e realizzazione di una piattaforma robotica hardware originale, con l’obiettivo di superare i limiti prestazionali ed economici delle attuali soluzioni low-cost.

A corredo, saranno sviluppati sistemi cyber-fisici (CPS), concepiti sia come dispositivi ausiliari da integrare nel robot (es. sensoristica avanzata), sia come sistemi dotati di intelligenza stand-alone.

Infine, si procederà all’ingegnerizzazione di un prototipo robotico completo, già esistente e funzionante a livello di laboratorio. L’obiettivo finale è la transizione da questo prototipo a prodotti derivati, pronti per una potenziale industrializzazione.

Obiettivi

L’ obiettivo è di implementare nuovi modelli antropomorfici di interazione tra uomo e robot per naturalizzare l’interazione utilizzando eventualemte dispositivi cyber fisici per arricchire le capacità espressive e percettive del robot.

L’ obiettivo complessivo è formato dai seguenti obiettivi parziali ma comunque auto consistenti:

• Interazione vocale: in stretta collaborazione con i colleghi che si occupano di NLP, definizione e implementazione di un linguaggio di interazione (interna) sistema coversazionale-robot che possa codificare gli aspetti multimodali della comunicazione.

• Interpretazione dei gesti: Implementazione di algoritmi per l’interpretazione delle posizioni dell’interlocutore. Esso è necessario per l’obiettivo precedente. Infatti, consentirà di rispondere a richieste di tipo indicali come: “Parlami di quell’oggetto” semplicemente indicandolo.

• Espressività del robot: Realizzazione di capacita espressive, coerenti con l’interazione, come il tono della voce, gli aspetti posturali e l’espressività facciale.

• Capacità indicali: Implementazione di capacità indicali basate su puntamento laser.

• Empatia: Realizzazione di capacità empatiche. Ad esempio la capacità di comprendere le espressioni facciali o più in generale il l’umore (mood) dell’interlocutore.

Campi Applicativi

I principali campi applicativi sono: l’education, dove l’interazione tra robot e bambini può supportare metodi didattici. Beni culturali, ovvero assistenza museale in cui le capacità di interpretazione indicale sarebbero una innovazione per questo campo applicativo. Medicina, in particolare assistenza post degenza di pazienti.

Area Tematica

Cyber-Physical Systems and Robotics

Keywords

Robotics; Human-Robot Interaction; Cognitive; Embodied Systems, ROS.

Responsabile del Gruppo

Prodotto della ricerca

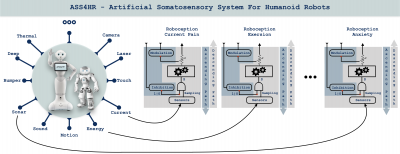

ASS4HR è sia un progetto sia un’implementazione ROS (Robot Operating System) di un sistema somatosensoriale artificiale per un robot umanoide. Il design prende ispirazione dal modello biologico ed è stato adattato alle caratteristiche del robot. L’implementazione si basa sull’uso del paradigma dei soft sensors.

ASS4HR è sia un progetto sia un’implementazione ROS (Robot Operating System) di un sistema somatosensoriale artificiale per un robot umanoide. Il design prende ispirazione dal modello biologico ed è stato adattato alle caratteristiche del robot. L’implementazione si basa sull’uso del paradigma dei soft sensors.

ASS4HR permette al robot di provare sensazioni che noi chiamiamo “roboceptions”, utilizzando i dati dei sensori di base di cui è dotato. In questo modo, il robot è consapevole delle sue condizioni fisiche e può adattare il suo comportamento.

Per ogni “ roboception” che costituisce il sistema somatosensoriale artificiale, è stato implementato sia il percorso ascendente che il percorso discendente. Pertanto, ASS4HR consente di sperimentare, modulare o inibire le “roboceptions”. In questo modo, ogni robot può avere il proprio carattere.

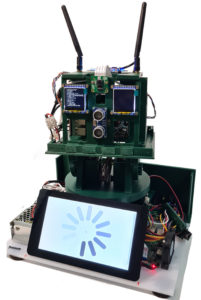

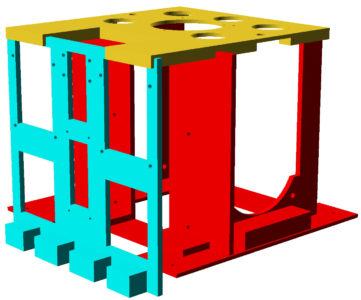

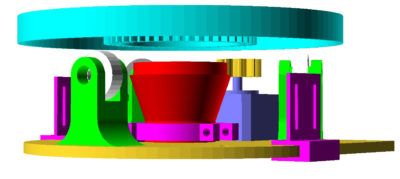

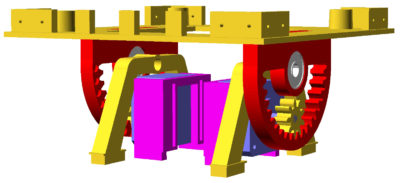

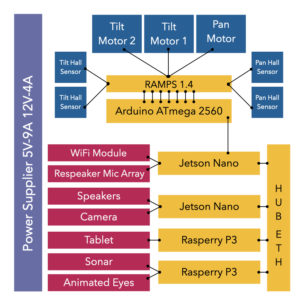

Q-ro Project

The idea of designing and building Q-ro, starting from scratch, allowed us to bring together many of the best features of robots already created in a single project. The project originates from the following considerations:

• Limitations: Low to medium-cost robots have numerous functional and technical-operational limitations;

• Accessibility of resources: commercial platforms such as Pepper and Nao, among the most popular today as social robots, do not allow full access to hardware resources and have a proprietary SDK;

• Costs: platforms with many features are expensive and cannot be used in small and medium-sized projects except as one-time prototypes. An experiment with dozens of robots costing tens of thousands of dollars/euros per robot is virtually unimaginable;

• Functionality: design and build a robot, which costs a few hundred dollars/euros, equipped with most of the functions of more expensive robots;

• Scalability: design and build a modular and scalable robot, which allows obtaining, from time to time, appropriate prototypes for specific applications